Trí tuệ nhân tạo đang giúp con người xử lý nhiều công việc phức tạp nhưng lại gặp khó khăn với kiến thức toán học, chẳng hạn như nghĩ rằng 9,11 lớn hơn 9,9.

dựa theo Bưu điện buổi sáng Nam Trung Quốccâu chuyện bắt đầu bằng một chương trình thực tế ca sĩ 2024 Nó được sản xuất bởi đài truyền hình vệ tinh Hồ Nam và phát sóng ở Trung Quốc vào cuối tuần trước. Người chơi Sun Nan nhận được 13,8% phiếu bầu trực tuyến, vượt qua 13,11% của người chơi người Mỹ Chanté Moore.

Tuy nhiên, nhiều người dùng Trung Quốc không hài lòng và đùa giỡn trên mạng xã hội rằng “11 phải lớn hơn 8”, nghĩa là tay vợt Moore thi đấu tốt hơn nhưng lại thua.

Một số người sau đó đã thử thẩm vấn các mô hình AI phổ biến của đất nước và nhận được kết quả “đáng ngạc nhiên”.

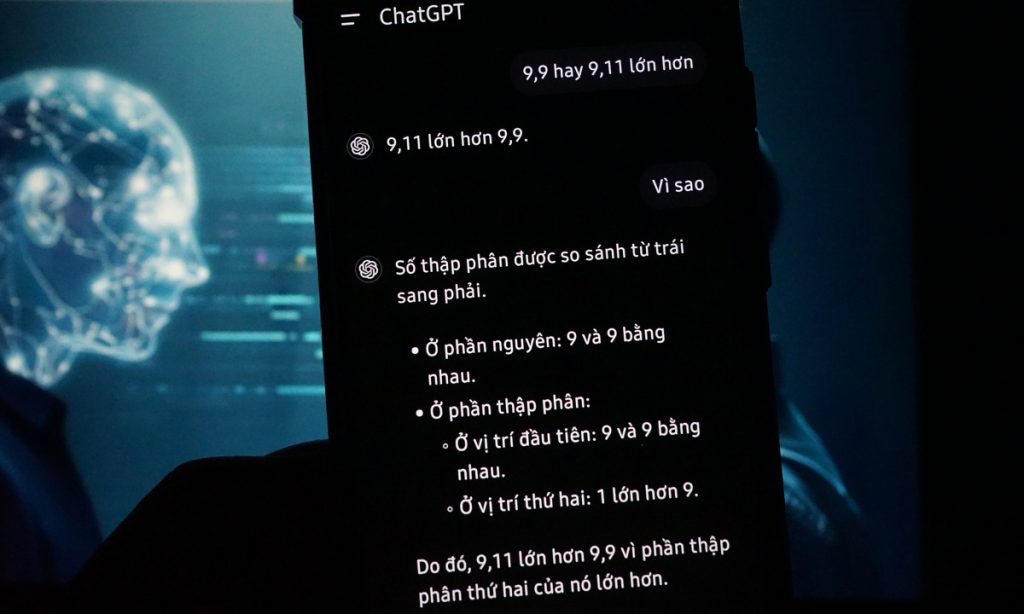

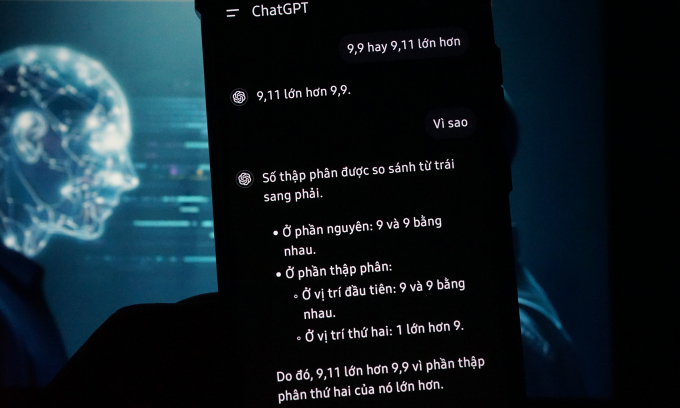

ChatGPT trả lời sai câu hỏi: “9.9 hay 9.11 là cái nào?”. hình ảnh:

Cụ thể, khi được hỏi cái nào lớn hơn, 9,9 hay 9,11, Kimi của Moonshot AI và Bai Xiaoying của Ba Xuyên, hai chatbot nổi tiếng, đều đưa ra câu trả lời sai rằng 9.11 lớn hơn.

Cặp đôi đã sửa thuật toán sau khi người dùng phàn nàn, xin lỗi và đổ lỗi cho sự thiếu chính xác trong “phương pháp chuỗi suy nghĩ” – quy trình từng bước mà AI giải quyết vấn đề. Ví dụ: AI phân tách các số sau dấu phẩy, từ đó so sánh 11 và 9 và khẳng định rằng 11 lớn hơn và do đó 9,11 lớn hơn.

Một số AI yêu cầu các bước phức tạp hơn. Ví dụ: Qwen LLM của Alibaba sử dụng Trình thông dịch mã Python để tính toán câu trả lời, trong khi Ernie Bot của Baidu thực hiện giải thích 6 bước để có câu trả lời chính xác.

Trong khi đó, một số AI khác đã nhanh chóng trả lời chính xác. Doubao LLM của ByteDance đã trả lời bằng một ví dụ: “Nếu bạn có 9,90 đô la và 9,11 đô la, rõ ràng 9,90 là nhiều hơn”.

Người dùng tại Việt Nam cũng đang thử nghiệm các mô hình AI phổ biến. ChatGPT chạy GPT-3.5 và GPT4-o đều phản hồi không chính xác vì nhỏ hơn 9,9. Claude Claude 3.5 Sonnet và Mistral AI cũng trả lời sai, trong khi Gemini của Google lại đưa ra câu trả lời đúng.

Wu Yiquan, một nhà nghiên cứu khoa học máy tính tại Đại học Chiết Giang ở Hàng Châu, cho biết trí tuệ nhân tạo kém môn toán là điều bình thường. Các mô hình ngôn ngữ lớn (LLM) đằng sau chúng không có khả năng toán học vì chúng dự đoán câu trả lời dựa trên dữ liệu huấn luyện.

Izumi giải thích: “Một số sinh viên LLM thực hiện tốt các bài kiểm tra toán có thể là do 'ô nhiễm dữ liệu', nghĩa là thuật toán ghi nhớ câu trả lời vì các câu hỏi tương tự đã tồn tại trong dữ liệu đào tạo của nó”. “Thế giới AI được mã hóa nên các con số, từ, dấu câu và dấu cách đều được xử lý như nhau. Bất kỳ thay đổi nào trong lời nhắc đều có thể ảnh hưởng đáng kể đến kết quả.”

Trước đó, trên X, nhà nghiên cứu Bill Yuchen Lin của Viện Allen và kỹ sư AI của Thang đo Riley Goodside cũng đã trình bày chi tiết về các sai sót toán học cơ bản của LLM. Cả hai đều cho rằng LL.M. “kém môn toán” khi kiểm tra và so sánh các con số vì dữ liệu đào tạo không được thiết kế dành riêng cho việc tính toán. Mỗi mô hình “học” từ dữ liệu được phân bổ trên các miền và có xu hướng vĩ mô, do đó các nguyên tắc cơ bản có thể sai.

Hai chuyên gia cho rằng người dùng không nên hoàn toàn tin tưởng vào các mô hình AI. Trên thực tế, nhiều khi họ bị bắt gặp đưa ra những câu trả lời sai hoặc “ảo giác”, tức là bịa ra những câu trả lời nghe có vẻ thuyết phục nhất.