Theo kịp một ngành phát triển nhanh như AI là một yêu cầu cao. Vì vậy, cho đến khi AI có thể làm điều đó cho bạn, đây là tổng hợp hữu ích các câu chuyện gần đây trong thế giới học máy, cùng với các nghiên cứu và thử nghiệm đáng chú ý mà chúng tôi chưa đề cập riêng.

Nhân tiện, TechCrunch có kế hoạch sớm ra mắt bản tin AI. Giữ nguyên. Trong thời gian chờ đợi, chúng tôi đang tăng nhịp độ của chuyên mục AI bán thường xuyên, trước đây là hai lần một tháng (hoặc lâu hơn), lên hàng tuần – vì vậy hãy chú ý đến nhiều ấn bản hơn.

Tuần này trong lĩnh vực AI, OpenAI một lần nữa thống trị chu kỳ tin tức (bất chấp những nỗ lực hết mình của Google) với việc ra mắt sản phẩm, nhưng cũng có một số âm mưu cung điện. Công ty đã tiết lộ GPT-4o, mô hình sáng tạo có khả năng nhất của mình và chỉ vài ngày sau đó đã giải tán một cách hiệu quả một nhóm làm việc về vấn đề phát triển các biện pháp kiểm soát nhằm ngăn chặn các hệ thống AI “siêu thông minh” hoạt động bất hảo.

Có thể đoán trước được việc giải tán đội đã tạo ra rất nhiều tiêu đề. Báo cáo – bao gồm cả báo cáo của chúng tôi – gợi ý rằng OpenAI đã ưu tiên nghiên cứu an toàn của nhóm để tung ra các sản phẩm mới như GPT-4o nói trên, cuối cùng dẫn đến việc hai người đồng lãnh đạo của nhóm, Jan Leike và đồng sáng lập OpenAI Ilya Sutskever, phải từ chức.

AI siêu thông minh ở thời điểm này mang tính lý thuyết hơn là thực tế; Không rõ khi nào – hoặc liệu – ngành công nghệ có đạt được những đột phá cần thiết để tạo ra AI có khả năng hoàn thành bất kỳ nhiệm vụ nào mà con người có thể làm hay không. Nhưng tin tức trong tuần này dường như đã xác nhận một điều: rằng lãnh đạo của OpenAI – đặc biệt là Giám đốc điều hành Sam Altman – ngày càng chọn ưu tiên các sản phẩm hơn các biện pháp bảo vệ.

Altman được cho là đã “ chọc tức” Sutskever bằng cách gấp rút ra mắt các tính năng hỗ trợ AI tại hội nghị nhà phát triển đầu tiên của OpenAI vào tháng 11 năm ngoái. Và anh ấy được cho là đã chỉ trích Helen Toner, giám đốc tại Trung tâm An ninh và Công nghệ mới nổi của Georgetown và là cựu thành viên hội đồng quản trị của OpenAI, về một bài báo mà cô ấy là đồng tác giả đưa ra cách tiếp cận an toàn của OpenAI dưới góc độ phê phán – đến mức anh ta đã cố gắng đẩy cô ấy ra khỏi bảng.

Trong khoảng một năm qua, OpenAI đã để cửa hàng chatbot của mình chứa đầy thư rác và (được cho là) đã lấy cắp dữ liệu từ YouTube theo các điều khoản dịch vụ của nền tảng, đồng thời bày tỏ tham vọng cho phép AI của mình tạo ra các mô tả về nội dung khiêu dâm và máu me. Chắc chắn, vấn đề an toàn dường như đã bị xếp sau ở công ty – và ngày càng nhiều nhà nghiên cứu về an toàn của OpenAI đã đi đến kết luận rằng công việc của họ sẽ được hỗ trợ tốt hơn ở những nơi khác.

Dưới đây là một số câu chuyện đáng chú ý khác về AI trong vài ngày qua:

- OpenAI + Reddit: Trong một tin tức khác về OpenAI, công ty đã đạt được thỏa thuận với Reddit để sử dụng dữ liệu của trang xã hội này để đào tạo mô hình AI. Phố Wall hoan nghênh thỏa thuận này với vòng tay rộng mở – nhưng người dùng Reddit có thể không hài lòng lắm.

- AI của Google: Google đã tổ chức hội nghị nhà phát triển I/O thường niên vào tuần này, trong thời gian đó nó đã ra mắt ở trên của các sản phẩm AI. Chúng tôi đã tổng hợp chúng ở đây, từ Veo tạo video đến các kết quả do AI sắp xếp trong Google Tìm kiếm cho đến các bản nâng cấp lên ứng dụng chatbot Gemini của Google.

- Nhân chủng học thuê Krieger: Mike Krieger, một trong những người đồng sáng lập Instagram và gần đây hơn là người đồng sáng lập ứng dụng tin tức cá nhân Artifact (mà công ty mẹ của TechCrunch là Yahoo mới mua lại), sẽ gia nhập Anthropic với tư cách là giám đốc sản phẩm đầu tiên của công ty. Ông sẽ giám sát cả nỗ lực của người tiêu dùng và doanh nghiệp.

- AI cho trẻ em: Anthropic đã công bố vào tuần trước rằng họ sẽ bắt đầu cho phép các nhà phát triển tạo ra các ứng dụng và công cụ tập trung vào trẻ em được xây dựng trên các mô hình AI của mình – miễn là họ tuân theo các quy tắc nhất định. Đáng chú ý, các đối thủ như Google không cho phép tích hợp AI của họ vào các ứng dụng hướng đến lứa tuổi trẻ hơn.

- Liên hoan phim AI: Công ty khởi nghiệp AI Runway đã tổ chức liên hoan phim AI lần thứ hai vào đầu tháng này. Mang đi? Một số khoảnh khắc mạnh mẽ hơn trong buổi giới thiệu không đến từ AI mà đến từ nhiều yếu tố con người hơn.

Học máy nhiều hơn

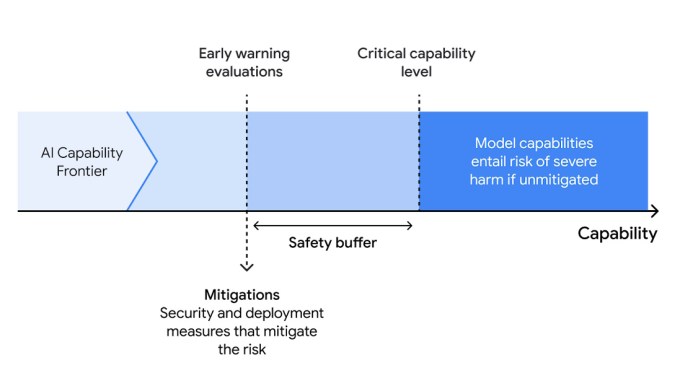

An toàn AI rõ ràng là ưu tiên hàng đầu trong tuần này với sự ra đi của OpenAI, nhưng Google Deepmind đang tiếp tục phát triển với “Khuôn khổ an toàn biên giới” mới. Về cơ bản, đó là chiến lược của tổ chức nhằm xác định và hy vọng ngăn chặn bất kỳ khả năng chạy trốn nào – đó không nhất thiết phải là AGI, nó có thể là một trình tạo phần mềm độc hại bị điên hoặc tương tự.

Khung này có ba bước: 1. Xác định các khả năng có hại tiềm tàng trong một mô hình bằng cách mô phỏng các lộ trình phát triển của nó. 2. Đánh giá các mô hình thường xuyên để phát hiện khi nào chúng đã đạt đến “mức khả năng quan trọng” đã biết. 3. Áp dụng kế hoạch giảm thiểu để ngăn chặn việc rò rỉ (bởi người khác hoặc chính nó) hoặc việc triển khai có vấn đề. Có nhiều chi tiết hơn ở đây . Nghe có vẻ giống như một chuỗi hành động hiển nhiên, nhưng điều quan trọng là phải chính thức hóa chúng, nếu không mọi người sẽ chỉ ủng hộ nó mà thôi. Đó là cách bạn có được AI xấu.

Một rủi ro khá khác đã được các nhà nghiên cứu của Cambridge xác định, những người thực sự lo ngại về sự gia tăng nhanh chóng của các chatbot mà người ta huấn luyện dựa trên dữ liệu của một người đã chết để cung cấp một mô phỏng bề ngoài về người đó. Bạn có thể (như tôi) thấy toàn bộ khái niệm này hơi ghê tởm, nhưng nó có thể được sử dụng trong việc quản lý đau buồn và các tình huống khác nếu chúng ta cẩn thận. Vấn đề là chúng ta không cẩn thận.

Nhà nghiên cứu chính Katarzyna Nowaczyk-Basińska cho biết: “Lĩnh vực AI này là một bãi mìn về mặt đạo đức. “Chúng ta cần bắt đầu suy nghĩ ngay bây giờ về cách giảm thiểu rủi ro tâm lý và xã hội của sự bất tử kỹ thuật số, bởi vì công nghệ đã có sẵn ở đây.” Nhóm xác định nhiều trò gian lận, kết quả tốt và xấu tiềm ẩn, đồng thời thảo luận khái niệm nói chung (bao gồm cả dịch vụ giả mạo) trong một bài báo đăng trên Philosophy & Technology. Black Mirror một lần nữa dự đoán tương lai!

Trong các ứng dụng ít đáng sợ hơn của AI, các nhà vật lý tại MIT đang xem xét một công cụ hữu ích (đối với họ) để dự đoán pha hoặc trạng thái của hệ vật lý, thường là một nhiệm vụ thống kê có thể trở nên khó khăn hơn với các hệ thống phức tạp hơn. Nhưng việc đào tạo một mô hình học máy dựa trên dữ liệu phù hợp và tạo nền tảng cho nó với một số đặc điểm vật chất đã biết của hệ thống thì bạn sẽ có cho mình một cách hiệu quả hơn đáng kể để thực hiện nó. Chỉ là một ví dụ khác về cách ML đang tìm kiếm những ngóc ngách ngay cả trong khoa học tiên tiến.

Tại CU Boulder, họ đang nói về cách sử dụng AI trong quản lý thảm họa. Công nghệ này có thể hữu ích để dự đoán nhanh nơi cần tài nguyên, lập bản đồ thiệt hại, thậm chí giúp đào tạo lực lượng ứng phó, nhưng mọi người (có thể hiểu được) do dự khi áp dụng nó trong các tình huống sinh tử.

Giáo sư Amir Behzadan đang cố gắng thúc đẩy điều đó, nói rằng “AI lấy con người làm trung tâm dẫn đến các hoạt động ứng phó và khắc phục thảm họa hiệu quả hơn bằng cách thúc đẩy sự hợp tác, hiểu biết và hòa nhập giữa các thành viên trong nhóm, những người sống sót và các bên liên quan”. Họ vẫn đang ở giai đoạn hội thảo, nhưng điều quan trọng là phải suy nghĩ sâu sắc về vấn đề này trước khi cố gắng tự động hóa việc phân phối viện trợ sau một cơn bão.

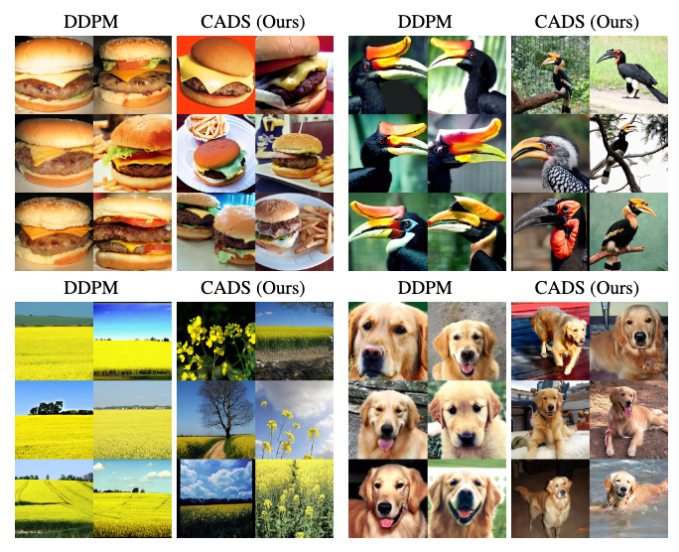

Cuối cùng là một số công việc thú vị của Disney Research, đang xem xét cách đa dạng hóa đầu ra của các mô hình tạo hình ảnh khuếch tán, có thể tạo ra kết quả tương tự lặp đi lặp lại đối với một số gợi ý. Giải pháp của họ? “Chiến lược lấy mẫu của chúng tôi loại bỏ tín hiệu điều hòa bằng cách thêm nhiễu Gaussian giảm đơn điệu theo lịch trình vào vectơ điều hòa trong quá trình suy luận để cân bằng tính đa dạng và căn chỉnh điều kiện.” Đơn giản là tôi không thể diễn đạt nó tốt hơn bản thân mình.

Kết quả là sự đa dạng rộng hơn nhiều về góc độ, cài đặt và hình thức chung trong kết quả đầu ra của hình ảnh. Đôi khi bạn muốn điều này, đôi khi không, nhưng thật tuyệt khi có được lựa chọn này.