Meta đã có một cú hích rõ rệt vào năm ngoái với Segment Anything, một mô hình máy học có thể nhanh chóng và đáng tin cậy xác định và phác thảo hầu như bất cứ thứ gì trong hình ảnh. Phần tiếp theo, được CEO Mark Zuckerberg ra mắt trên sân khấu vào thứ Hai tại SIGGRAPH, đưa mô hình vào lĩnh vực video, cho thấy lĩnh vực này đang chuyển động nhanh như thế nào.

Phân đoạn là thuật ngữ kỹ thuật dùng để chỉ thời điểm mô hình thị giác nhìn vào một bức ảnh và chọn ra các phần: “đây là một con chó, đây là một cái cây phía sau con chó” hy vọng là vậy, chứ không phải “đây là một cái cây mọc ra từ một con chó”. Điều này đã diễn ra trong nhiều thập kỷ, nhưng gần đây nó đã trở nên tốt hơn và nhanh hơn rất nhiều, với Segment Anything là một bước tiến lớn.

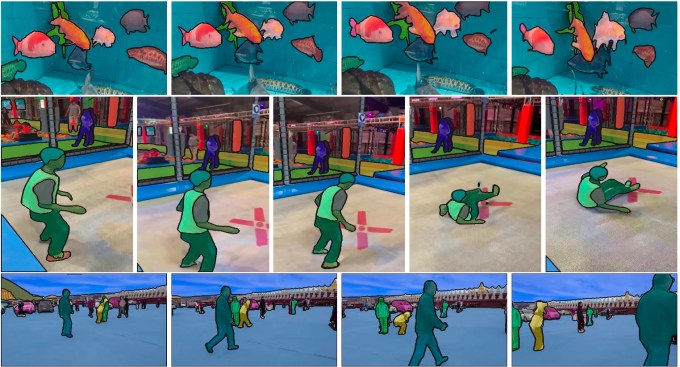

Segment Anything 2 (SA2) là một bước tiếp theo tự nhiên vì nó áp dụng cho video chứ không chỉ cho hình ảnh tĩnh; mặc dù tất nhiên bạn có thể chạy mô hình đầu tiên trên từng khung hình của video riêng lẻ, nhưng đây không phải là quy trình làm việc hiệu quả nhất.

“Các nhà khoa học sử dụng thứ này để nghiên cứu, như rạn san hô và môi trường sống tự nhiên, những thứ như vậy. Nhưng có thể làm điều này trong video và để nó không bị bắn và nói cho nó biết những gì bạn muốn, thì thật tuyệt”, Zuckerberg nói trong một cuộc trò chuyện với CEO của Nvidia Jensen Huang.

Tất nhiên, xử lý video đòi hỏi nhiều tính toán hơn và đó là minh chứng cho những tiến bộ trong toàn ngành về hiệu quả mà SA2 có thể chạy mà không làm tan chảy trung tâm dữ liệu. Tất nhiên, đây vẫn là một mô hình lớn cần phần cứng mạnh để hoạt động, nhưng phân đoạn nhanh và linh hoạt thực tế là không thể ngay cả một năm trước.

Mô hình này, giống như mô hình đầu tiên, sẽ mở và miễn phí sử dụng, và không có thông tin nào về phiên bản lưu trữ, điều mà các công ty AI này đôi khi cung cấp. Nhưng có bản demo miễn phí.

Tất nhiên, một mô hình như vậy cần rất nhiều dữ liệu để đào tạo và Meta cũng đang phát hành một cơ sở dữ liệu lớn, có chú thích gồm 50.000 video mà họ đã tạo ra chỉ cho mục đích này. Trong bài báo mô tả SA2, một cơ sở dữ liệu khác gồm hơn 100.000 video “có sẵn nội bộ” cũng được sử dụng để đào tạo và cơ sở dữ liệu này không được công khai — Tôi đã yêu cầu Meta cung cấp thêm thông tin về cơ sở dữ liệu này và lý do tại sao nó không được phát hành. (Chúng tôi đoán rằng nó có nguồn gốc từ các hồ sơ Instagram và Facebook công khai.)

Meta đã là người dẫn đầu trong lĩnh vực AI “mở” trong vài năm nay, mặc dù thực tế là (như Zuckerberg đã nêu ý kiến trong cuộc trò chuyện) đã làm như vậy trong một thời gian dài, với các công cụ như PyTorch. Nhưng gần đây hơn, LLaMa, Segment Anything và một số mô hình khác mà họ đưa ra miễn phí đã trở thành một rào cản tương đối dễ tiếp cận đối với hiệu suất AI trong các lĩnh vực đó, mặc dù “tính mở” của chúng là vấn đề gây tranh cãi.

Zuckerberg đề cập rằng sự cởi mở này không hoàn toàn xuất phát từ lòng tốt của họ tại Meta, nhưng điều đó không có nghĩa là ý định của họ không trong sáng:

“Đây không chỉ giống như một phần mềm mà bạn có thể xây dựng — bạn cần một hệ sinh thái xung quanh nó. Nó thậm chí gần như không hoạt động tốt nếu chúng ta không mã nguồn mở, đúng không? Chúng tôi không làm điều này vì chúng tôi là những người vị tha, mặc dù tôi nghĩ rằng điều này sẽ hữu ích cho hệ sinh thái — chúng tôi làm điều này vì chúng tôi nghĩ rằng điều này sẽ làm cho thứ mà chúng tôi đang xây dựng trở nên tốt nhất.”

Dù sao thì nó chắc chắn sẽ được sử dụng tốt. Hãy xem GitHub tại đây.