Viện An toàn Vương quốc Anh, cơ quan an toàn AI mới thành lập của Vương quốc Anh, đã phát hành một bộ công cụ được thiết kế để “tăng cường an toàn AI” bằng cách giúp ngành công nghiệp, tổ chức nghiên cứu và học viện phát triển các đánh giá AI dễ dàng hơn.

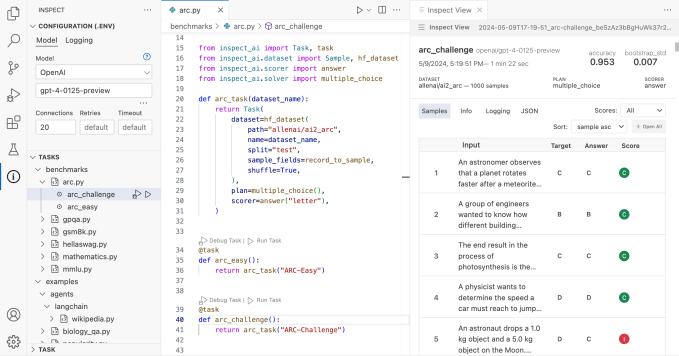

Được gọi là Kiểm tra, bộ công cụ – có sẵn theo giấy phép nguồn mở, cụ thể là Giấy phép MIT – nhằm mục đích đánh giá các khả năng nhất định của các mô hình AI, bao gồm kiến thức cốt lõi và khả năng suy luận của mô hình, đồng thời tạo điểm số dựa trên kết quả.

Trong một thông cáo báo chí công bố tin tức này vào thứ Sáu, Viện An toàn tuyên bố rằng Kiểm tra đánh dấu “lần đầu tiên một nền tảng kiểm tra an toàn AI do một cơ quan được nhà nước hậu thuẫn dẫn đầu đã được phát hành để sử dụng rộng rãi hơn”.

Chủ tịch Viện An toàn Ian Hogarth cho biết: “Sự hợp tác thành công trong thử nghiệm an toàn AI có nghĩa là có một cách tiếp cận chung, dễ tiếp cận để đánh giá và chúng tôi hy vọng rằng Kiểm tra có thể là một khối xây dựng”. “Chúng tôi hy vọng thấy cộng đồng AI toàn cầu sử dụng Kiểm tra để không chỉ thực hiện các thử nghiệm an toàn mô hình của riêng họ mà còn giúp thích ứng và xây dựng trên nền tảng nguồn mở để chúng tôi có thể tạo ra các đánh giá chất lượng cao trên diện rộng.”

Như chúng tôi đã viết trước đây, các tiêu chuẩn AI rất khó – đặc biệt là vì các mô hình AI tinh vi nhất hiện nay là hộp đen có cơ sở hạ tầng, dữ liệu đào tạo và các chi tiết quan trọng khác là các chi tiết được các công ty tạo ra chúng giữ bí mật. Vậy Kiểm tra giải quyết thách thức này như thế nào? Chủ yếu bằng cách có thể mở rộng và mở rộng sang các kỹ thuật thử nghiệm mới.

Kiểm tra được tạo thành từ ba thành phần cơ bản: bộ dữ liệu, bộ giải và bộ ghi điểm. Bộ dữ liệu cung cấp mẫu cho các bài kiểm tra đánh giá. Người giải quyết thực hiện công việc thực hiện các bài kiểm tra. Và người chấm điểm đánh giá công việc của người giải và tổng hợp điểm từ các bài kiểm tra thành số liệu.

Các thành phần tích hợp của Kiểm tra có thể được tăng cường thông qua các gói của bên thứ ba được viết bằng Python.

Trong một bài đăng trên X, Deborah Raj, một nhà nghiên cứu tại Mozilla và là nhà đạo đức AI nổi tiếng, đã gọi Thanh tra là “bằng chứng cho sức mạnh của đầu tư công vào công cụ nguồn mở cho trách nhiệm giải trình của AI”.

Clément Delangue, Giám đốc điều hành của công ty khởi nghiệp AI Hugging Face, đã đưa ra ý tưởng tích hợp thư viện mô hình của Kiểm tra với Ôm khuôn mặt hoặc tạo bảng xếp hạng công khai với kết quả đánh giá của bộ công cụ.

Bản phát hành của Kiểm tra được đưa ra sau khi cơ quan chính phủ tiểu bang – Viện Tiêu chuẩn và Công nghệ Quốc gia (NIST) – đưa ra NIST GenAI, một chương trình nhằm đánh giá các công nghệ AI tổng hợp khác nhau bao gồm AI tạo văn bản và hình ảnh. NIST GenAI có kế hoạch phát hành các điểm chuẩn, giúp tạo ra hệ thống phát hiện tính xác thực của nội dung và khuyến khích phát triển phần mềm để phát hiện thông tin giả mạo hoặc gây hiểu lầm do AI tạo ra.

Vào tháng 4, Hoa Kỳ và Vương quốc Anh đã công bố hợp tác để cùng phát triển thử nghiệm mô hình AI tiên tiến, sau các cam kết được công bố tại Hội nghị thượng đỉnh về an toàn AI của Vương quốc Anh tại Bletchley Park vào tháng 11 năm ngoái. Là một phần của sự hợp tác, Hoa Kỳ dự định thành lập viện an toàn AI của riêng mình, nơi sẽ chịu trách nhiệm đánh giá rủi ro từ AI và AI tổng hợp.