Mark Zuckerberg cho biết Meta đang triển khai các cụm máy chủ chứa hơn 100.000 GPU Nvidia H100, có giá khoảng 40.000 USD mỗi chip.

Giám đốc điều hành Meta Mark Zuckerberg cho biết trong hội nghị thu nhập quý 3 năm 2024: “Mô hình ngôn ngữ quy mô lớn Llama 4 đang được phát triển. Chúng tôi đang thử nghiệm nó trên các cụm máy chủ sử dụng hơn 100.000 chip H100 đào tạo, nhiều hơn bất kỳ hệ thống nào được công bố trong phương tiện truyền thông.

Ông không tiết lộ chính xác số lượng H100s Meta sở hữu. Mỗi chip Nvidia H100 trên thị trường có giá bán từ 30.000-40.000 USD, nghĩa là nếu chỉ tính chi phí mua GPU, cụm máy chủ của Meta sẽ có giá trị hơn 4 tỷ USD.

Con số 100.000 Zuckerberg đề cập được cho là so sánh với siêu máy tính Colossus được startup xAI của tỷ phú Elon Musk triển khai kể từ mùa hè. Ông chủ Tesla sau này mô tả đây là siêu máy tính lớn nhất thế giới, được trang bị 100.000 chip H100 để huấn luyện chatbot Grok.

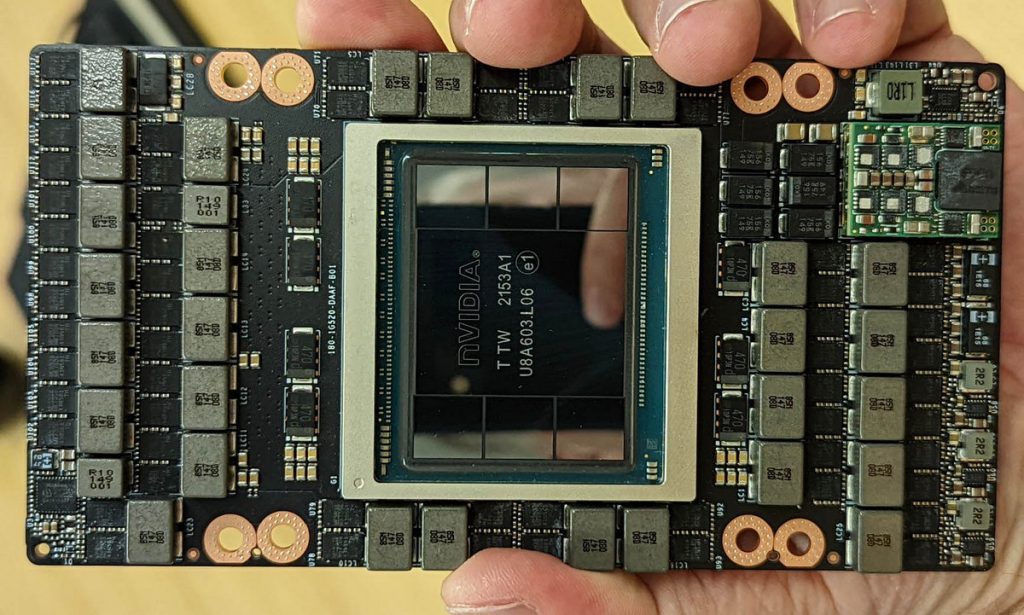

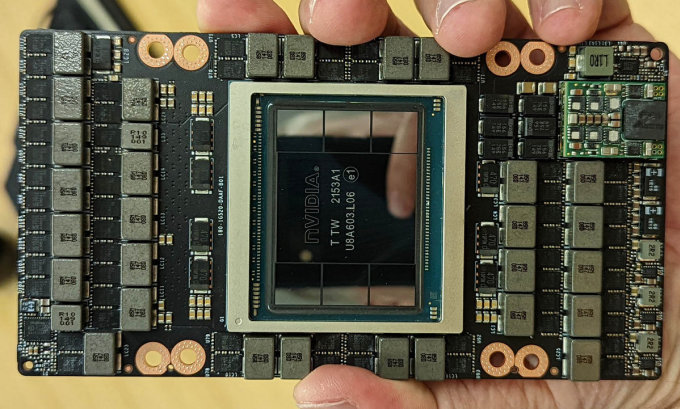

Card được trang bị chip Nvidia H100. hình ảnh: Phục vụ tại nhà

Zuckerberg tuyên bố rằng Llama 4 sẽ có sức mạnh và khả năng suy luận cao hơn cũng như nhanh hơn các mẫu trước đó. Ông nói: “Mô hình nhỏ của nó có thể được ra mắt sớm nhất là vào năm 2025”.

Số lượng chip H100 mỗi công ty có đang trở thành yếu tố khi tuyển dụng và thu hút nhân tài. Giám đốc điều hành Perplexity Aravind Srinivas đã tiết lộ điều này khi đang tìm cách thuê một nhà nghiên cứu cấp cao tại Meta.

“Bạn có biết nhà nghiên cứu đó nói gì không? Ông ấy nói: Hãy quay lại với tôi khi công ty có 10.000 chip H100”, Srinivas nói.

Elon Musk cũng tuyên bố vào đầu tuần này rằng xAi sẽ sớm tăng gấp đôi hệ thống máy chủ của mình, nâng số lượng chip H100 và H200 lên xấp xỉ 200.000 trong những tháng tới.

GPU H100, sản phẩm kế thừa của A100 trị giá 10.000 USD, được gọi là con ngựa thồ trong ngành trí tuệ nhân tạo, nơi GPU thống trị việc đào tạo AI với khả năng thực hiện một loạt phép tính song song. H100 được sử dụng để xây dựng các mô hình ngôn ngữ lớn (LLM), là cốt lõi của các ứng dụng AI như ChatGPT.

Hiện tại, Nvidia có nhiều đơn đặt hàng GPU nhất, trong khi các công ty khác như AMD cũng tung ra các sản phẩm tương tự.

(theo Người trong cuộc, Reuters)